Inverse Reinforcement Learning

강화학습에서 reward는 굉장히 중요하다. Policy를 학습하는데 있어서, intrinsic이든 extrinsic이든 Agent가 거의 대부분의 정보를 얻는 경로이기 때문이다.

일반적으로 강화학습에서는 사람이 reward를 일일히 정해주지만, 실제로 그 reward에 따라 “desirable” action이 나오지 않을 수도 있다. 또한 이렇게 직접 reward를 정해주는 "reward shaping" 과정은 매우 어려우며, 도메인 지식을 많이 필요로 하면서 손을 많이 타는 과정이다. 특히 원하는 task가 복잡할수록 reward function을 명시적으로 정한다는것이 어렵거나 사실상 불가능해진다.

이런 어려움에서 나온 개념이 Inverse Reinforcement Learning (IRL)이다. IRL은 전문가 혹은 시연자의 optimal 및 suboptimal behavior에서 reward를 거꾸로 추론하거나 크게는 이렇게 추론한 reward기반의 policy를 학습하는것을 말한다. 행동심리학적 관점에서는, 관측한 사람들의 행동에서 사람들이 어떤것을 원하는지를 찾아내고자 하는 알고리즘이라고도 볼 수 있다.

파블로 피카소는 "Good artist copy, great artist steal."라고 말했다. 강화학습 관점에서보면 어떤 행동을 그대로 따라하는것보다 그 행동의 내적 의도를 이해하고 그걸 능가하는 policy를 학습하려는 IRL의 목적과 어느정도 통하는게 있는 말이다.

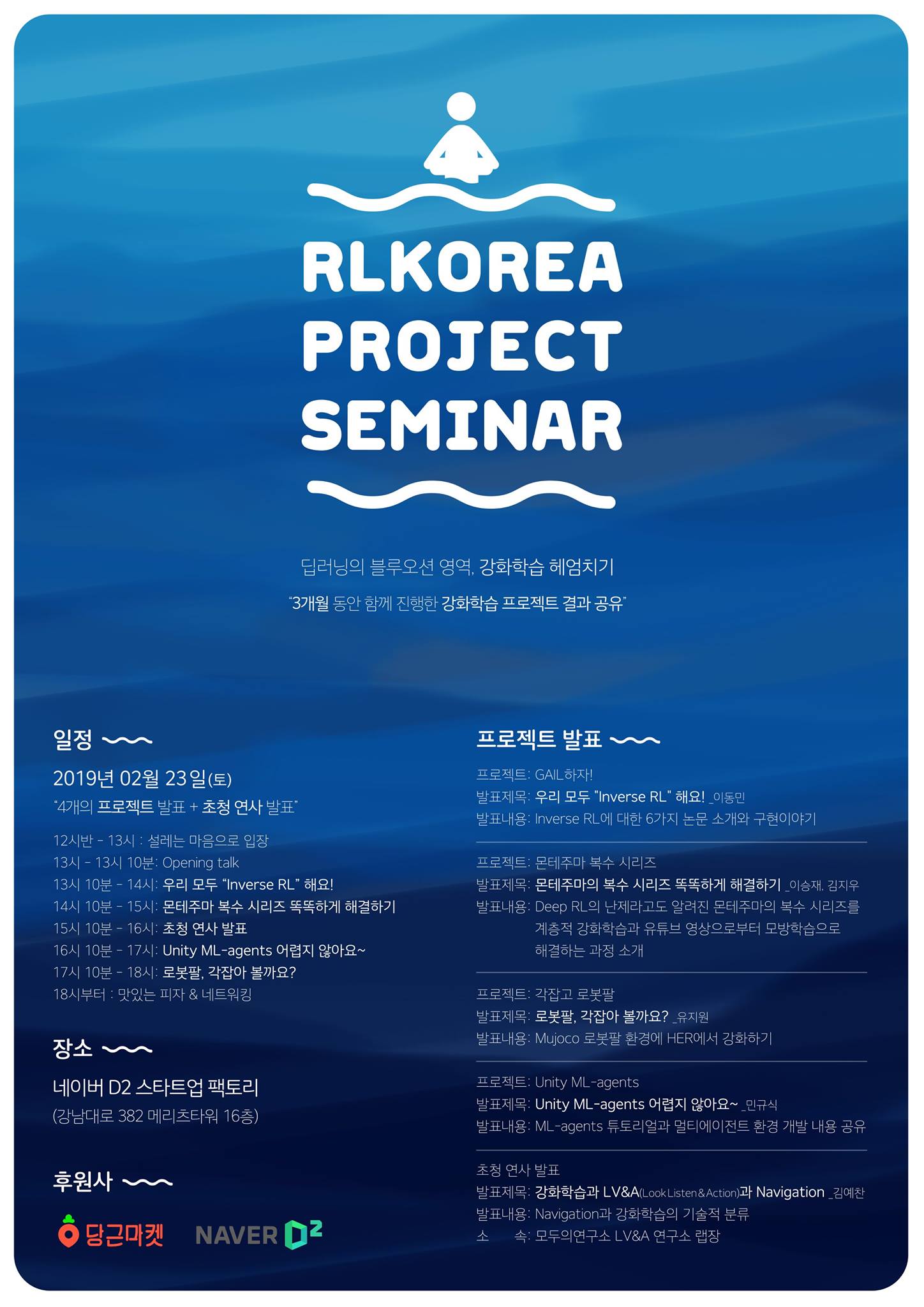

이런 재밌는 IRL을 한번 같이 공부하고 구현해보자! 하는 의도에서 Reinforcement Learning Korea에서 몇몇 분들과 함께 2018년 10월부터 2019년 2월까지 관련 논문 6개를 읽고 구현을 해보는 단기 사이드 프로젝트를 진행했다.

블로그: reinforcement-learning-kr.github.io/2019/01/22/0_lets-do-irl-guide/

Let's do Inverse RL Guide

RLKorea 블로그

reinforcement-learning-kr.github.io

Github: github.com/reinforcement-learning-kr/lets-do-irl

발표: